OSCAR论文解读

Introduction

先前的VLP模型采用的方法都是将图像区域特征$v={v_1,\cdots,v_K}$和文本嵌入序列$w={w_1,\cdots,w_T}$简单连接起来输入transformer,然后利用self-attention暴力学习图像区域和文本的对齐,这种对齐由于其弱监督性和存在噪声而十分低效

具体来说,这种方法的缺点是 (1) Ambiguity:通过目标检测器得到的图像区域不可避免地存在重叠,导致视觉嵌入的抽取存在模糊性 (2) Lack of grounding:图像中的区域与文本中的单词没有明确的对齐,导致了弱监督性

注意到图像中的明显目标可以被现代目标检测器准确地检测到,而且这些目标往往会出现在配对的文本中,例如在COCO数据集上,图像及其配对文本共享至少1、2、3个对象的百分比分别为49.7%、22.2%和12.9%

因此,该论文的目标是引入在图像中检测到的目标标签作为锚点,以增强监督

Method

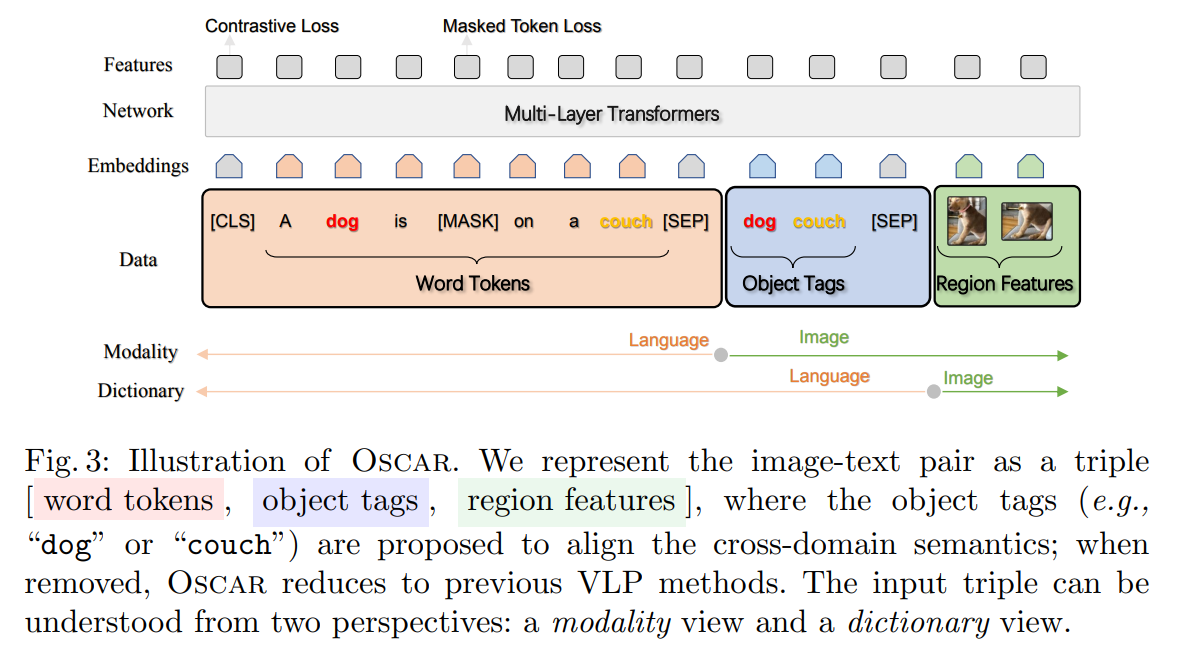

OSCAR将数据集中的image-text pair处理为Word-Tag-Image三元组$(w,q,v)$作为输入

其中w是文本的单词嵌入序列,q是从图像中检测到的对象标签的单词嵌入序列,v是图像的区域特征集合

v和q的获取方式如下:使用Faster R-CNN抽取每个区域的视觉语义$(v’,z)$,其中$v’\in R^P$是$P$维区域视觉特征,$z$是$R$维位置向量,之后拼接$v’$和$v$并通过一个线性层映射为$v$,$q$则为检测到的目标tags嵌入序列

OSCAR采用的模型是预训练BERT,Vision-Language预训练任务从两个角度进行设计

Dictionary View:由于检测到的object tags和文本中的word token共享同一个字典,因此它们在同一语义空间,而图像区域特征在另一语义空间

于是第一个loss是Masked Token Loss (MTL),mask掉$[w,q]$中的部分token,再根据上下文预测这些token

Modality View:从数据集模态上区分,$[q,v]$被视为图像模态,来自同一语义空间,而$w$被视为语言模态

于是第二个loss是Contrastive Loss:以50%的概率替换$q$采样得到负样本,并在[CLS]输出上添加分类层判断输入是否是正确的三元组

Adapting to V+L Tasks

Image-Text Retrieval:转化为二分类问题,微调时采样若干aligned pair对及其相应unaligned pair,使用CLS token对应的输出进行二分类;推理时根据二分类的输出概率进行排序

Image Captioning:微调时采用Masked Token Loss,只对caption text部分进行mask;对于推理,开始时输入text部分只有一个[MASK] token,输出其预测后替换[Masked],并追加新的[Masked],直到预测出[STOP] token

VQA/GQA:此处为抽取式回答,论文视其为多分类问题,对于一个提问,首先按照与人工回答的相似性为候选库中的回答赋予soft target score,然后将问题、图像区域和tags拼接后输入OSCAR,使用CLS token对应的输出进行多分类,使用预测分数与soft target score计算交叉熵

Natural Language Visual Reasoning for Real (NLVR2):任务是判断一段文本是否是一对图片的正确陈述,论文将两张图象分别与文本拼接形成两次输入,得到两个CLS对应输出,将其拼接后输入二分类器

Experiment

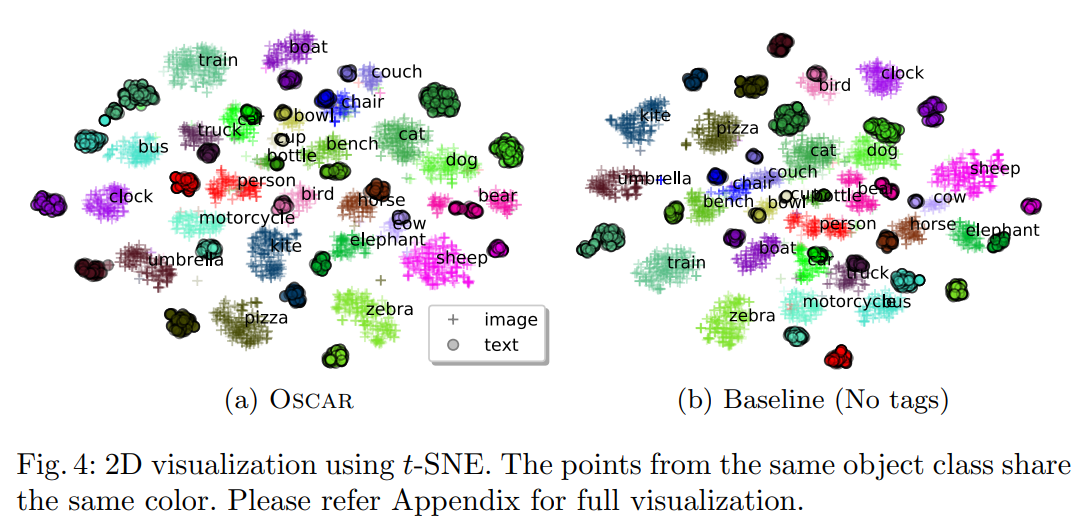

定量实验和消融实验具体可以看论文,这里展示一个比较有意思的结果,如图所示,引入object tags后

- 同一目标两种模态之间的距离大大缩短,例如zebra

- 具有相近语义的目标类距离更近了,例如 furniture (chair, couch, bench)